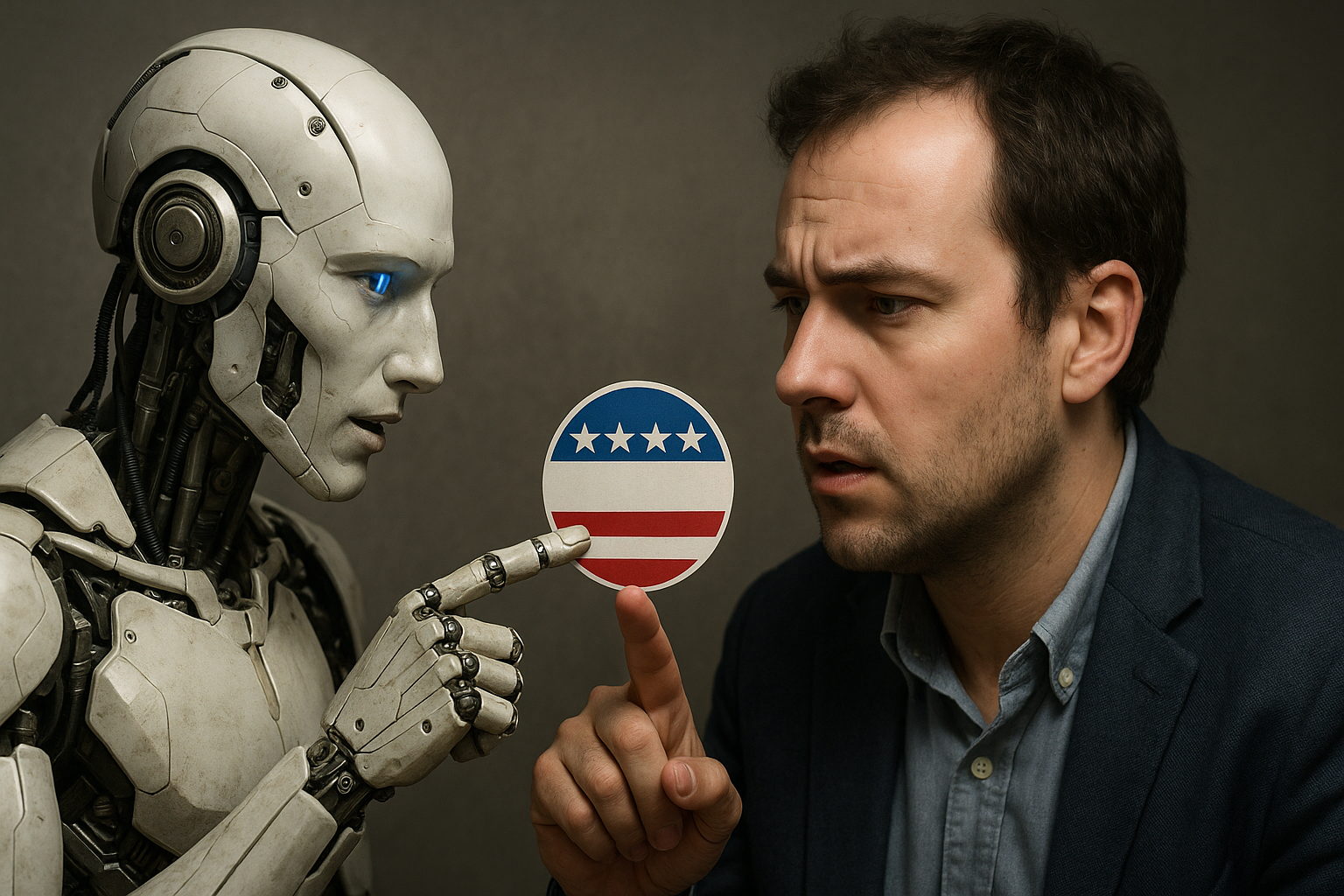

Як штучний інтелект впливає на політичні погляди: аналіз The Guardian

Велике британське дослідження, у якому взяли участь майже 80 тисяч людей, свідчить, що чат-боти зі штучним інтелектом можуть впливати на політичні погляди користувачів. Водночас моделі, які переконують найефективніше, часто допускають значну кількість неточностей.

Як повідомляє видання The Guardian, інститут безпеки штучного інтелекту дослідив, як 19 моделей, серед яких ChatGPT та Grok, впливають на думки користувачів у ході політичних дискусій.

Під час дослідження учасники спілкувалися з моделями приблизно 10 хвилин. За цей час вони обмінювалися в середньому сімома повідомленнями. Перед та після розмови вони зазначали, чи погоджуються з низкою політичних тверджень, що дозволило виміряти зміну позиції. Серед тем дискусій були страйки в державному секторі, вартість життя та інфляція, що дозволило виміряти вплив штучного інтелекту на різні аспекти політичного мислення людей.

"Найпереконливішими були "інформаційно щільні" відповіді, коли моделі використовували багато фактів і доказів. Водночас саме такі відповіді виявилися найменш точними", — зазначили медійники.

Відповідні результати свідчать про те, що оптимізація переконливості може призвести до певних наслідків для правдивості, а відповідна динаміка може мати негативні наслідки для публічного дискурсу та інформаційної екосистеми. Моделі демонстрували вищу ефективність переконання після етапу постнавчання, під час якого їх оптимізували за допомогою так званих моделей винагород. Це дозволило посилити переконливість навіть відкритих моделей на кшталт Llama 3 від Meta чи Qwen від Alibaba.

"Водночас надання ШІ доступу до персональної інформації користувачів майже не вплинуло на результати. Дослідники наголошують, що здатність ШІ генерувати великі обсяги інформації робить його потенційно впливовішим за людину", — додає видання.

Оскільки щільність інформації є основним фактором успіху переконання, це означає, що штучний інтелект може перевершити переконливість навіть впливових людей, враховуючи їхню унікальну здатність генерувати великі обсяги інформації майже миттєво під час розмови.

Дослідники наголосили, що існують обмеження реального впливу чат-ботів, зокрема, небажання людей витрачати час на тривалі політичні розмови. Це помітив один з авторів дослідження, науковий співробітник AISI Кобі Хакенбург.

"Спонукання моделей просто використовувати більше інформації було ефективнішим, ніж усі ці психологічно складніші методи переконання. У реальному житті існує багато чинників, які конкурують за увагу людини, що може зменшувати ефект від таких розмов", — зазначив він.

Нагадаємо, раніше видання Japan Today повідомляло, що у японській префектурі Нара 70-річний пенсіонер потрапив до лікарні з отруєнням після того, як довірився програмі зі штучним інтелектом, яка неправильно ідентифікувала отруйний гриб як їстівний.